Az Anthropic innovatív politikája a katasztrofális AI kockázatok megfékezésére

A technológiai fejlődés korában az Anthropic a felelősségvállalás jelzőfényeként lép fel és olyan politikát vezet be, amelynek célja, hogy egyensúlyt teremtsen az AI fejlődése és a biztonság között.

-

Az Anthropic kiadja a Responsible Scaling Policy-t (RSP) a nagy léptékű AI-val kapcsolatos kockázatok mérséklése érdekében.

-

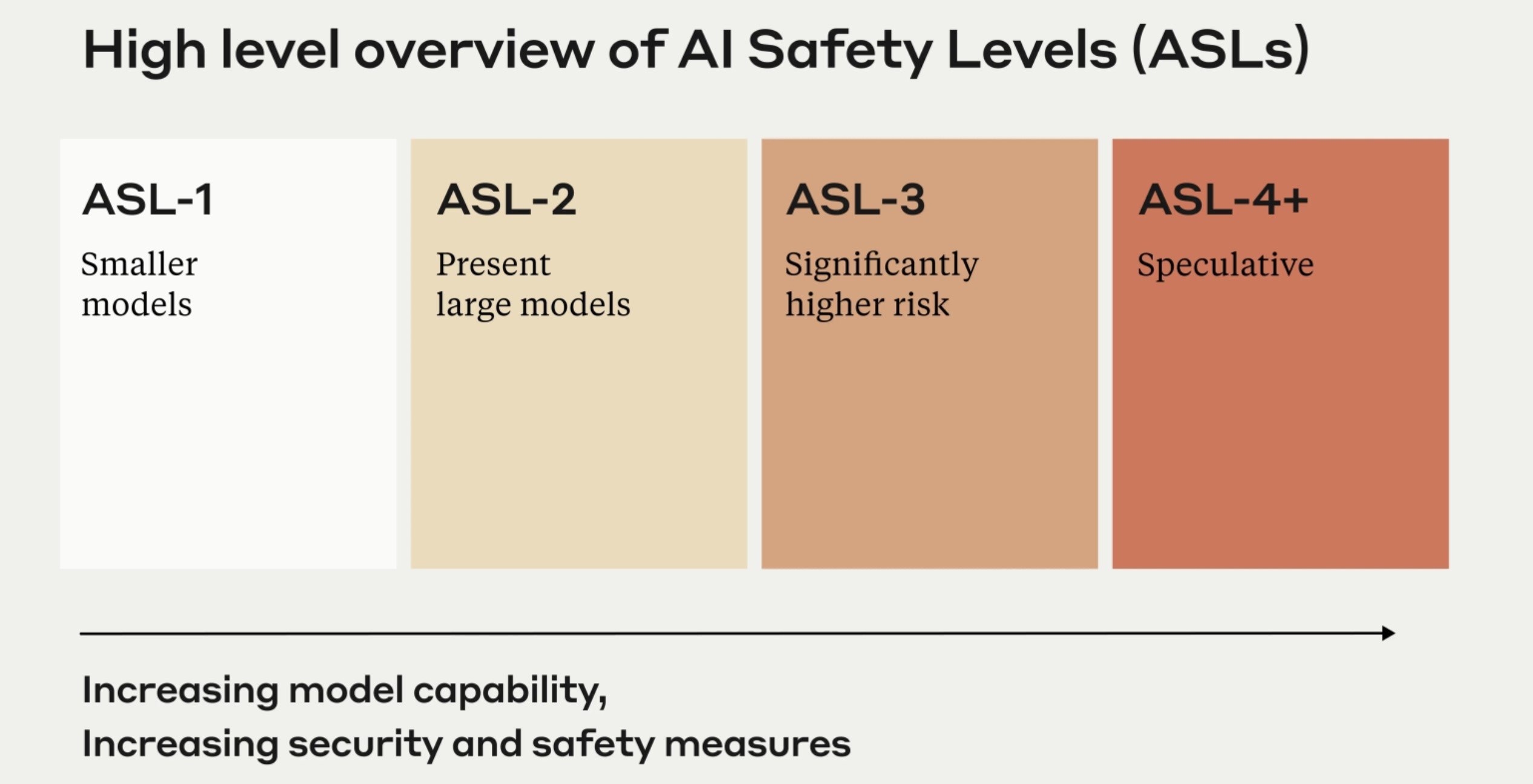

A politika bevezeti az AI biztonsági szinteket a különböző AI-rendszerek potenciális kockázatainak kezelésére.

Ha többet akarsz tudni, kövess minket Facebookon! -

Az Anthropic hangsúlyozza a politika fejlődő jellegét és a független felügyelet fontosságát.

A Claude chatbotjáról ismert Anthropic az új Responsible Scaling Policy (RSP) segítségével döntő lépést tett a mesterséges intelligencia felelős növekedésének biztosítása felé. Ez a politika proaktív válasz az AI-által jelentett potenciális katasztrofális kockázatokra és olyan forgatókönyvekkel foglalkozik, amelyekben az AI hatalmas pusztítást vagy pénzügyi veszteséget okozhat.

Az RSP az Anthropic elkötelezettségét bizonyítja a fejlett mesterséges intelligencia modellekkel kapcsolatos növekvő veszélyek megfékezése mellett. Ennek a politikának a középpontjában az AI biztonsági szintek (ASL) állnak, egy olyan kockázati kategorizálási rendszer, amelyet az Egyesült Államok kormányának biológiai biztonsági szintjei ihlettek. Az ASL-0-tól (alacsony kockázat) az ASL-3-ig (magas kockázat) terjedő szintek célja, hogy a különböző mesterséges intelligencia rendszerek potenciális veszélyeit aprólékos értékelés, telepítés és felügyelet révén felmérjék és kezeljék.

Sam McCandlish, az Anthropic társalapítója hangsúlyozta a politika dinamikus jellegét, megjegyezve, hogy az a tapasztalatok és a visszajelzések alapján alkalmazkodik. A vállalat víziója, hogy a versenynyomást kulcsfontosságú biztonsági kérdések megoldásává alakítsa. Ezáltal a biztonságosabb, kifinomultabb mesterséges intelligencia rendszerek fejlesztése új képességek felszabadításához vezet, nem pedig elhamarkodott, ellenőrizetlen növekedéshez. Ez a megközelítés azonban nem jár kihívások nélkül. McCandlish elismeri a kockázatok értékelésének bonyolultságát, különösen akkor, ha a modellek elrejthetik valódi képességeiket.

Az Anthropic bejelentése a mesterséges intelligencia ágazatban egyre növekvő ellenőrzés és szabályozás közepette történik. Az OpenAI-ban gyökerező és az olyan óriások, mint a Google jelentős támogatását élvező Anthropic kiemelkedik az AI biztonság és összehangolás terén. A Claude nevű AI chatbotjuk jól példázza a biztonság és az etika iránti elkötelezettségüket, mivel az „alkotmányos AI” megközelítést alkalmazza a káros felszólítások ellensúlyozására. Ez a módszer, amely a felügyelt és a megerősítő tanulást kombinálja, ellenőrzöttebb AI viselkedést kínál, ami jelentős ugrást jelent az etikus és biztonságos AI-rendszerek fejlesztése terén.

- Legfrissebb

- Nem a technológia hiányzik, hanem a szokás: az Eurostat szerint az európaiak többsége nem érzi szükségesnek az AI-eszközöket

- A Google törölte a Disney-szereplős AI-videókat a YouTube-ról, miután felszólító levelet kapott

- Codex Mortis: ez a videójáték már teljes egészében mesterséges intelligenciával készült, ki is próbálhatod

- GPT-5.2 bemutató: az OpenAI új csúcsmodellje már nem csak válaszol, hanem munkatársként működik

- Hogyan növekednek gyorsabban a vállalkozások az AI-alapú digitális marketingplatformokkal?

- Meglepő igazság: több milliárdos interakció elemzéséből derült ki, hogyan is használjuk a mesterséges intelligenciát

- Az AI-tagadás mint vállalati kockázat: tényleg csak digitális moslékot csinál a mesterséges intelligencia?

- Ez lesz az OpenAI új gyónási rendszere: amikor a modell maga vallja be, ha hibázott

- A chatbotok sokkal hatékonyabban formálják a politikai véleményt, mint a tévés kampányhirdetések

- Áttörés a mellrákszűrésben? A DeepHealth új platformja már most átírja a radiológia jövőjét

- Képernyőidő

- Hogyan reagálj, ha a szülői felügyet app riasztást küld? Mi a következő lépés?

- Tudtad, hogy a legújabb kutatások szerint a közösségi média egyáltalán nem káros, sőt, hasznos is lehet a gyerekek számára? És te sem akarod elhinni?

- Megbolondult a Gmail? Nem nálad volt a hiba!

- 149 millió belépési adat keringett az interneten, és még csak nem is hackertámadásról van szó

- Lehet persze legyinteni arra, ha egy MI-szolgáltatás képes bárkit levetkőztetni, de hárommillió ilyen kép készült tizenegy nap alatt

- Legnépszerűbb címkék

- OpenAI

- ChatGPT

- generatív AI

- AI

- Microsoft

- innováció

- NVIDIA

- GPT-4

- technológia