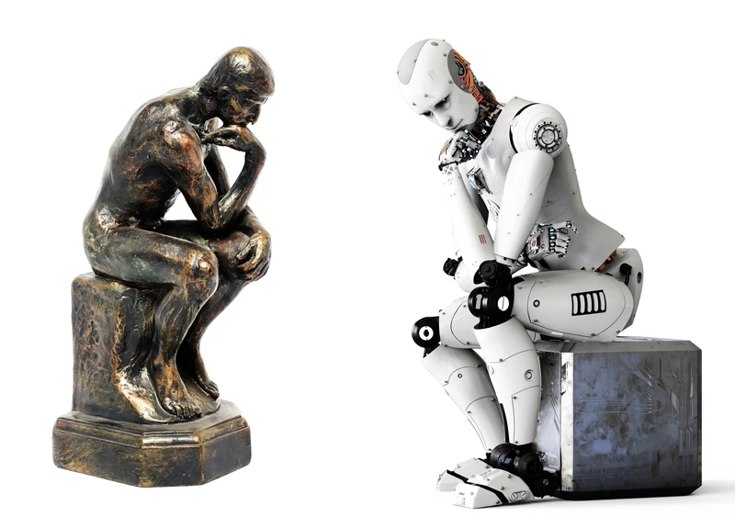

Egy szakértő szerint a nagy nyelvi modellek szinte biztosan képesek gondolkodni

Az elmúlt hónapokban újra fellángolt a vita arról, hogy vajon a nagy érvelő modellek (Large Reasoning Models, LRM) valóban képesek-e gondolkodni. Most egy érdekes megközelítést mutatunk.

Az Apple provokatív tanulmánya, The Illusion of Thinking („A gondolkodás illúziója”) szerint nem: az LRM-ek csupán mintafelismeréssel utánozzák a gondolkodást, valójában nem értik, amit tesznek. A cég érve szerint ezek a modellek nem tudnak algoritmusokat következetesen végigvinni, ha a feladat mérete nő.

Debasish Ray Chawdhuri, a Talentica Software vezető mérnöke ezzel szemben úgy véli: a következtetés téves.

„Ha egy embert, aki ismeri a Hanoi-torony megoldásának algoritmusát, húsz koronggal állítunk szembe, ő sem tudja kézzel kiszámolni a lépéseket. Ez mégsem bizonyítja, hogy nem tud gondolkodni” – írja.

Chawdhuri szerint az Apple érve legfeljebb annyit bizonyít, hogy nincs bizonyíték arra, hogy az LRM-ek ne tudnának gondolkodni. Sőt, állítása szerint „szinte biztos”, hogy képesek rá – és el is magyarázza, miért.

Mit nevezünk gondolkodásnak?

A szerző a problémamegoldás szempontjából definiálja a gondolkodást, és lépésről lépésre veti össze az emberi agy folyamatait a láncolt gondolatmenet-alapú (chain-of-thought, CoT) érveléssel.

- Problémareprezentáció: az emberi agy prefrontális kérge a feladat megtartásáért, részekre bontásáért és a célkitűzésért felel. Az LRM-ek ugyanígy „megragadják” a bemenet szerkezetét a tokenek közötti minták alapján.

- Mentális szimuláció: az emberek „belső beszéddel” gondolkodnak; ez a CoT-hoz hasonló, amikor a modell saját szöveges magyarázatot generál a következtetéseihez.

- Mintafelismerés és előhívás: az agy a hippocampus és a temporális lebeny segítségével hív elő korábbi tapasztalatokat, az LRM pedig a paramétereiben tárolt tudást aktiválja.

- Ellenőrzés és hibajavítás: az emberi ACC (anterior cinguláris kéreg) hibákat és ellentmondásokat figyel, míg a modell a belső konzisztenciát értékeli, és visszalép, ha zsákutcába jut.

- Ráébredés, újrakeretezés: amikor az ember „hátralép”, és új megoldást talál, az hasonló ahhoz, ahogy egy modell új érvelési irányt próbál ki, ha az előző kudarcot vallott.

Chawdhuri szerint ez a párhuzam nem véletlen: a DeepSeek-R1 modell például úgy tanult CoT-alapú érvelést, hogy nem kapott ilyen példákat a tanítás során, hanem a problémamegoldás közben tanult meg gondolkodni – hasonlóan ahhoz, ahogy az emberi agy folyamatosan alkalmazkodik.

A gondolkodás korlátai és alternatívái

A kritikusok szerint az LRM-ek nem képesek vizuális reprezentációra, ami az emberi gondolkodás egyik pillére. A szerző erre az aphantasia példáját hozza: léteznek emberek, akik nem tudnak mentálisan képeket alkotni, mégis kiválóan gondolkodnak absztrakt módon. „Ha ők képesek rá vizuális képalkotás nélkül, akkor a modellek is gondolkodhatnak vizuális komponens nélkül” – írja.

A kulcs szerinte három alapvető elem:

- mintafelismerés,

- munkamemória,

- visszalépés, ha a gondolatmenet nem vezet eredményre.

Mindez jelen van az LRM-ekben is: a minták a paraméterekben, a munkamemória a figyelmi rétegekben (KV-cache), a visszalépés pedig a CoT-alapú hibajavítás során valósul meg.

De miért tanulna „gondolkodni” egy token-előrejelző?

A „csak egy autokorrekt” érv szerinte félrevezető. A következő token előrejelzése ugyanis a lehető legáltalánosabb tudásreprezentációs forma, hiszen a nyelv – ellentétben a formális logikai rendszerekkel – képes bármilyen fogalmat, szabályt vagy absztrakciót kifejezni, akár önmagára is reflektálva.

Amikor tudást akarunk ábrázolni, szükségünk van egy nyelvre vagy jelrendszerre. A formális nyelvek – például az elsőrendű predikátumlogika – nagyon pontosak, de korlátozottak abban, amit kifejezhetnek.

Például az elsőrendű logika nem képes tulajdonságokat kifejezni olyan predikátumokról, amelyek önmagukban bizonyos feltételeket elégítenek ki, mert nem engedélyezi a „predikátumok predikátumait”. A magasabb rendű logikák képesek erre, de még ők sem tudnak elmosódott, pontatlan vagy absztrakt fogalmakat kezelni.

A természetes nyelv viszont teljes kifejezőerejű: bármilyen fogalmat, elvont vagy pontos gondolatot meg lehet vele fogalmazni, sőt a saját működését is képes leírni. Ez teszi kiváló eszközzé a tudás reprezentálására.

Az egyetlen kihívás, hogy a természetes nyelv bonyolultsága miatt nehéz kézzel feldolgozni. De nem is kell manuálisan értenünk, hogyan működik – a gépet adat segítségével megtaníthatjuk erre.

Egy következő token-előrejelző gép a megelőző tokenek kontextusa alapján számítja ki a következő token valószínűségi eloszlását. Egy olyan rendszer, amely ezt pontosan képes megtenni, valamilyen formában kénytelen tárolni a világra vonatkozó tudást.

Egyszerű példa: ha a mondat így hangzik, „A világ legmagasabb hegycsúcsa a Mount …”, a helyes előrejelzéshez („Everest”) a modellnek rendelkeznie kell ezzel az ismerettel.

Bizonyíték: a viselkedés maga

A szerző szerint a gondolkodás legfontosabb tesztje a viselkedés: ha egy rendszer képes új, nem tanult problémákat megoldani, akkor gondolkodik. Nyílt forrású modellek – nemcsak a zárt, kereskedelmi fejlesztések – már most képesek logikai feladatok és rejtvények megoldására, sokszor az átlagos, képzetlen ember szintjén vagy afölött.

„Ha egy rendszer viselkedése megfelel a gondolkodás eredményének, akkor minden ésszerű definíció szerint gondolkodik” – érvel Chawdhuri.

A láncolt gondolatmenet és az emberi kogníció közötti hasonlóságok, a modellek bizonyított érvelési képességei, valamint az a tény, hogy a kellően nagy és tanított rendszerek bármilyen kiszámítható feladatot képesek elvégezni, mind ugyanabba az irányba mutatnak: a rendszer képes a gondolkodásra.

- Legfrissebb

- Nem a technológia hiányzik, hanem a szokás: az Eurostat szerint az európaiak többsége nem érzi szükségesnek az AI-eszközöket

- A Google törölte a Disney-szereplős AI-videókat a YouTube-ról, miután felszólító levelet kapott

- Codex Mortis: ez a videójáték már teljes egészében mesterséges intelligenciával készült, ki is próbálhatod

- GPT-5.2 bemutató: az OpenAI új csúcsmodellje már nem csak válaszol, hanem munkatársként működik

- Hogyan növekednek gyorsabban a vállalkozások az AI-alapú digitális marketingplatformokkal?

- Meglepő igazság: több milliárdos interakció elemzéséből derült ki, hogyan is használjuk a mesterséges intelligenciát

- Az AI-tagadás mint vállalati kockázat: tényleg csak digitális moslékot csinál a mesterséges intelligencia?

- Ez lesz az OpenAI új gyónási rendszere: amikor a modell maga vallja be, ha hibázott

- A chatbotok sokkal hatékonyabban formálják a politikai véleményt, mint a tévés kampányhirdetések

- Áttörés a mellrákszűrésben? A DeepHealth új platformja már most átírja a radiológia jövőjét

- Képernyőidő

- A TikTok legújabb trendje: a szellőztetés!

- Már csak egy napig érhető el Steamen a táblás játékok akciója, érdemes még gyorsan körbenézni

- Mi ez a Google által készített Project Genie, amely éppen bedönti a játékfejlesztő cégek részvényeit?

- A gyerek, aki nem tud nyugton ülni – hiperaktivitás vagy a test üzenete?

- Sydney Sweeneyvel és a Deadpool íróival készül filmadaptáció a világ egyik legelismertebb kooperatív videójátékából

- Legnépszerűbb címkék

- OpenAI

- ChatGPT

- generatív AI

- AI

- Microsoft

- innováció

- NVIDIA

- GPT-4

- technológia