Az Eagle 7B: A költséghatékony, többnyelvű AI modellek új korszaka

Bemutatkozik az Eagle 7B, amely az innovatív architektúrájával forradalmasítja a többnyelvű nyelvfeldolgozást, a teljesítmény és a költséghatékonyság példátlan kombinációját kínálva.

-

Az Eagle 7B, egy kompakt, mégis erőteljes többnyelvű AI-modell, amely kiemelkedik a hatékonyság és a teljesítmény terén.

-

Az RWKV architektúrát használva az RNN-ek és a transzformátorok legjobb tulajdonságait ötvözi a költséghatékony működés érdekében.

Ha többet akarsz tudni, kövess minket Facebookon! -

Bizonyos korlátozások ellenére az Eagle 7B kiterjedt nyelvi támogatást kínál és szabadon elérhető a legkülönfélébb alkalmazásokhoz.

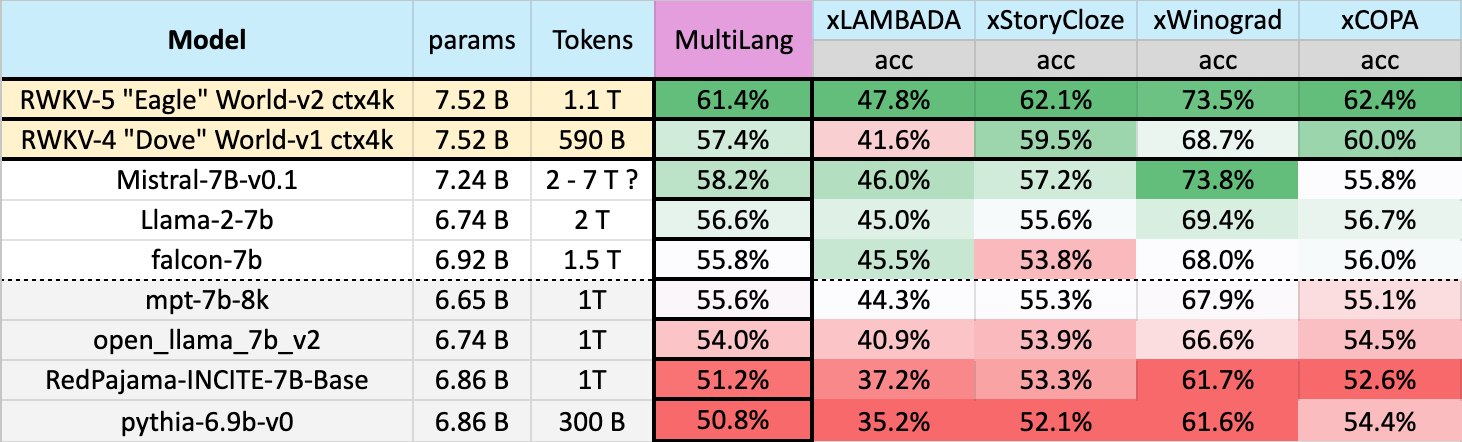

A mesterséges intelligencia dinamikus világában az Eagle 7B az innováció és a hatékonyság bizonyítékaként tűnik ki. Ezt a kompakt modellt egy nemzetközi közösség fejlesztette ki a Linux Alapítvánnyal együttműködésben, ami 23 nyelven felülmúlja az olyan bevált modelleket, mint a Mistral-7B, a Llama 2-7B és a Falcon-7B. Az Eagle 7B titkos összetevője az úttörő RWKV architektúra, amely zseniálisan ötvözi a transzformátorok párhuzamos képzési előnyeit a ismétlődő neurális hálózatok (RNN) következtetési hatékonyságával. Ez az egyedülálló kombináció lehetővé teszi az Eagle 7B számára, hogy csúcsszintű teljesítményt nyújtson, miközben jelentősen csökkenti a számítási költségeket.

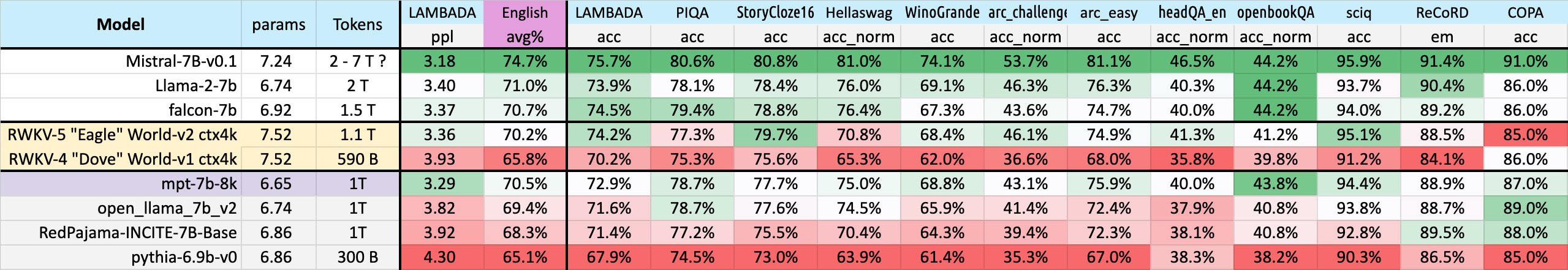

Az Eagle 7B méretét tekintve szerény, mindössze 7,52 milliárd paramétert tartalmaz, de képességei nem kicsik. Több mint 100 nyelven, több mint 1 trillió tokenre képezték ki, ami lehetővé teszi, hogy jóval a súlycsoportja fölé emelkedjen. A modell angol nyelvű teljesítménye, bár némileg elmarad a riválisoktól, még mindig versenyképes, különösen, ha figyelembe vesszük a kisebb képzési adathalmazt. Ami igazán kiemeli az Eagle 7B-t a többi modell közül, az a költséghatékonysága. Az RWKV-architektúra biztosítja, hogy a modell 10-szer, vagy akár 100-szor is alacsonyabb költségekkel működjön, ami vonzóvá teszi mind a személyes, mind a kereskedelmi felhasználás számára.

![]() Az Eagle 7B alapjául szolgáló RWKV-v5 architektúra jelentős előrelépést jelent az AI-technológiában. A hagyományos transzformációs modellekkel ellentétben, amelyek négyzetesen skálázódnak, az RWKV-v5 lineárisan skálázódik, ami azt jelenti, hogy ugyanolyan jól teljesít, miközben sokkal kevesebb erőforrást fogyaszt. Ez a lineáris skálázás, valamint a figyelemmechanizmus hiánya nemcsak a hatékonyságot növeli, hanem a méretezhetőséget is javítja. Ezáltal az Eagle 7B számos alkalmazáshoz – a nyelvi fordítástól a tartalomgenerálásig – életképes választássá válhat, elődeinek nagy számítási lábnyoma nélkül.

Az Eagle 7B alapjául szolgáló RWKV-v5 architektúra jelentős előrelépést jelent az AI-technológiában. A hagyományos transzformációs modellekkel ellentétben, amelyek négyzetesen skálázódnak, az RWKV-v5 lineárisan skálázódik, ami azt jelenti, hogy ugyanolyan jól teljesít, miközben sokkal kevesebb erőforrást fogyaszt. Ez a lineáris skálázás, valamint a figyelemmechanizmus hiánya nemcsak a hatékonyságot növeli, hanem a méretezhetőséget is javítja. Ezáltal az Eagle 7B számos alkalmazáshoz – a nyelvi fordítástól a tartalomgenerálásig – életképes választássá válhat, elődeinek nagy számítási lábnyoma nélkül.

Számos erőssége ellenére az Eagle 7B nem mentes a kihívásoktól. A felhasználóknak ügyelniük kell a prompt formázásra, mivel a modell érzékeny a bemenetek szerkezetére. Emellett a kiterjedt visszanézést igénylő feladatok a modell gyenge pontjai lehetnek. Mindazonáltal az Eagle 7B mögött álló csapat továbbra is elkötelezett a képességek javítása és bővítése mellett, és tervezi a nyelvi támogatás növelését, valamint egy kétbillió tokenre való felkészítést. Az Apache 2.0 licenc alatt elérhető Eagle 7B letölthető az Hugging Face oldaláról, ami bepillantást enged a hozzáférhető, többnyelvű mesterséges intelligencia jövőjébe.

- Legfrissebb

- Nem a technológia hiányzik, hanem a szokás: az Eurostat szerint az európaiak többsége nem érzi szükségesnek az AI-eszközöket

- A Google törölte a Disney-szereplős AI-videókat a YouTube-ról, miután felszólító levelet kapott

- Codex Mortis: ez a videójáték már teljes egészében mesterséges intelligenciával készült, ki is próbálhatod

- GPT-5.2 bemutató: az OpenAI új csúcsmodellje már nem csak válaszol, hanem munkatársként működik

- Hogyan növekednek gyorsabban a vállalkozások az AI-alapú digitális marketingplatformokkal?

- Meglepő igazság: több milliárdos interakció elemzéséből derült ki, hogyan is használjuk a mesterséges intelligenciát

- Az AI-tagadás mint vállalati kockázat: tényleg csak digitális moslékot csinál a mesterséges intelligencia?

- Ez lesz az OpenAI új gyónási rendszere: amikor a modell maga vallja be, ha hibázott

- A chatbotok sokkal hatékonyabban formálják a politikai véleményt, mint a tévés kampányhirdetések

- Áttörés a mellrákszűrésben? A DeepHealth új platformja már most átírja a radiológia jövőjét

- Képernyőidő

- Már csak egy napig érhető el Steamen a táblás játékok akciója, érdemes még gyorsan körbenézni

- Mi ez a Google által készített Project Genie, amely éppen bedönti a játékfejlesztő cégek részvényeit?

- A gyerek, aki nem tud nyugton ülni – hiperaktivitás vagy a test üzenete?

- Sydney Sweeneyvel és a Deadpool íróival készül filmadaptáció a világ egyik legelismertebb kooperatív videójátékából

- Egy új tanulmány szerint a képernyőidő korlátozása egyáltalán nem megoldás már semmire

- Legnépszerűbb címkék

- OpenAI

- ChatGPT

- generatív AI

- AI

- Microsoft

- innováció

- NVIDIA

- GPT-4

- technológia