Neurális hangjegyek: A Google AI-ja zenét generál az agyi aktivitásból

Képzeljünk el egy olyan világot, ahol a gondolataink zenévé alakíthatók. A Google legújabb AI-modellje ezt teszi valósággá, az agyi aktivitásból dallamokat hoz létre.

-

A Google új kutatási projektje, a Brain2Music az AI segítségével generál zenét az fMRI-adatokon keresztül rögzített agyi aktivitásból.

-

Az AI-modellt különböző zenei műfajokat hallgató tesztalanyok adatai alapján képezték ki, megtanulva az agyi aktivitás és a zenei elemek közötti kapcsolatot.

Ha többet akarsz tudni, kövess minket Facebookon! -

A generált zene, amely a műfaj, hangulat és hangszerelés tekintetében nagyon hasonlít az eredeti ingerekre.

A Google legújabb vállalkozása a mesterséges intelligencia és a zene világában nem kevesebb, mint úttörő. A technológiai óriás új kutatási projektje, a Brain2Music a mesterséges intelligencia segítségével az agyi aktivitás alapján hoz létre zenét. Ezt a tevékenységet funkcionális mágneses rezonancia képalkotó (fMRI) adatokkal rögzítik, így egyedülálló betekintést nyújtanak abba, hogyan reagál az agyunk a különböző zenei ingerekre.

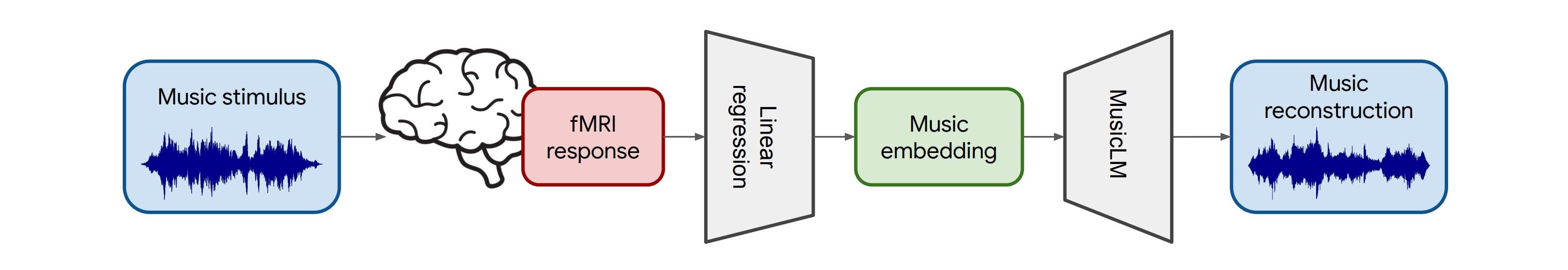

Az AI-modellt öt tesztalany adatai alapján képezték ki, akik különböző 15 másodperces zenei klipeket hallgattak a bluestól a rockig terjedő műfajokban. Ezeket az adatokat arra használták, hogy egy mély neurális hálózatot tanítsanak az agyi aktivitási minták és a zene különböző elemei, például a ritmus és az érzelmek közötti kapcsolatról. Miután betanították, a modell képes volt rekonstruálni a zenét egy fMRI-felvételből, alkalmazva a Google MusicLM programját, amely szövegből zenét generál.

Ennek az innovatív projektnek az eredményei valóban figyelemre méltóak. A generált zene, amely a műfaj, hangulat és hangszerelés tekintetében szorosan tükrözi az eredeti ingereket. Amikor például az inger Britney Spears „Oops!...I Did It Again” című dalának klipje volt az inger, az AI-által előállított rekonstrukciók hasonlóan popos és vidámak voltak. Ez az úttörő kutatás azt mutatja, hogy a modell hatékonyan képes "olvasni" az agyi mintákat, hogy az általunk hallgatott zenéhez hasonló zenét állítson elő.

- Legfrissebb

- Nem a technológia hiányzik, hanem a szokás: az Eurostat szerint az európaiak többsége nem érzi szükségesnek az AI-eszközöket

- A Google törölte a Disney-szereplős AI-videókat a YouTube-ról, miután felszólító levelet kapott

- Codex Mortis: ez a videójáték már teljes egészében mesterséges intelligenciával készült, ki is próbálhatod

- GPT-5.2 bemutató: az OpenAI új csúcsmodellje már nem csak válaszol, hanem munkatársként működik

- Hogyan növekednek gyorsabban a vállalkozások az AI-alapú digitális marketingplatformokkal?

- Meglepő igazság: több milliárdos interakció elemzéséből derült ki, hogyan is használjuk a mesterséges intelligenciát

- Az AI-tagadás mint vállalati kockázat: tényleg csak digitális moslékot csinál a mesterséges intelligencia?

- Ez lesz az OpenAI új gyónási rendszere: amikor a modell maga vallja be, ha hibázott

- A chatbotok sokkal hatékonyabban formálják a politikai véleményt, mint a tévés kampányhirdetések

- Áttörés a mellrákszűrésben? A DeepHealth új platformja már most átírja a radiológia jövőjét

- Képernyőidő

- Tudományos felfedezés: a testmozgás az agyunkat is megváltoztatja?

- Halálunk után a mesterséges intelligencia kezelné tovább a Facebook profilunkat?

- Drop Duchy – Complete Edition teszt szülőknek

- 2026-ban a laptop, a router, az okostelefon, de még a netszolgáltatás is drágulhat, ennek pedig a memória az oka

- Rekordot döntött a téli olimpia nézettsége: tarolt az HBO Max streaming és az Eurosport Magyarországon is

- Legnépszerűbb címkék

- OpenAI

- ChatGPT

- generatív AI

- AI

- Microsoft

- innováció

- NVIDIA

- GPT-4

- technológia