Az Nvidia H200: Óriási ugrás az AI-feldolgozási képességek terén

Az Nvidia H200 GPU-ja új mércét állít fel az AI-számítástechnika terén, mivel példátlan memória- és sávszélesség-fejlesztéssel büszkélkedhet.

-

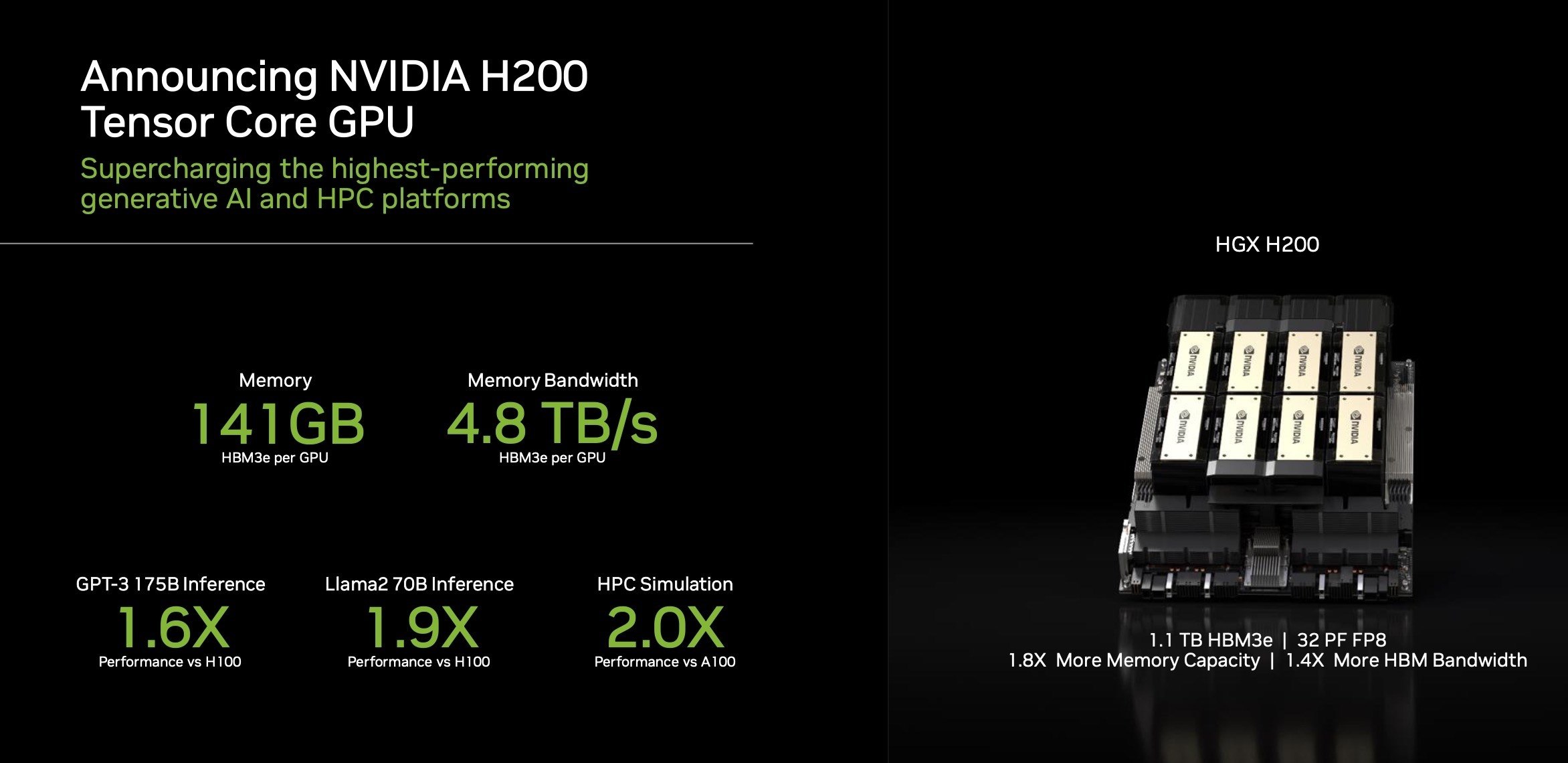

Az Nvidia új HGX H200 GPU-ja jelentősen felülmúlja a H100-ast, 1,4-szer nagyobb memória sávszélességet és 1,8-szor nagyobb memóriakapacitást kínál.

-

A H200 HBM3e memóriát használ, ami növeli a teljesítményét az AI modellek és a nagy teljesítményű számítási alkalmazások számára.

Ha többet akarsz tudni, kövess minket Facebookon! -

A fejlett funkciók ellenére az elérhetőséggel kapcsolatos aggályok továbbra is fennállnak, az Nvidia azon dolgozik, hogy a kínálat megfeleljen a nagy keresletnek.

Az Nvidia HGX H200 GPU bevezetése jelentős mérföldkövet jelent az AI-technológiában. Ez az új chip 1,4-szeres memória sávszélesség növekedéssel és 1,8-szoros memóriakapacitás növeléssel felülmúlja elődjét, a H100-ast. Ezek a fejlesztések létfontosságúak a generatív AI munka intenzív igényeinek kezeléséhez. A H200 debütálása kérdéseket vet fel az elérhetőségével kapcsolatban, különösen a H100 esetében tapasztalt ellátási korlátok miatt. Az Nvidia azt tervezi, hogy az első H200-as chipeket 2024 második negyedévében bocsátja ki, és a szélesebb körű elérhetőség biztosítása érdekében együttműködik a globális gyártókkal és felhőszolgáltatókkal.

A H200 egyik legfontosabb jellemzője, hogy az új, gyorsabb HBM3e memória specifikációt használja, ami a memória sávszélességét impozáns 4,8 terabyte/sec.-re növeli, ami jelentős ugrás a H100-as 3,35 terabyte/sec. sávszélességéhez képest. Ez a frissítés a teljes memóriakapacitást 141 GB-ra növeli az előd 80 GB-járól. Ian Buck, az Nvidia nagy teljesítményű számítási (HPC) termékekért felelős alelnöke kiemeli, hogy a fejlett memóriatechnológia integrálása nemcsak a teljesítményt gyorsítja az igényes AI modellekben, hanem optimalizálja a GPU kihasználtságát és hatékonyságát is.

A kompatibilitás a H200 másik erőssége, mivel úgy tervezték, hogy zökkenőmentesen integrálható legyen a már H100-at támogató rendszerekbe. Ez azt jelenti, hogy a felhőszolgáltatók könnyedén beépíthetik a H200-akat anélkül, hogy jelentős rendszermódosításokra lenne szükség. Az olyan nagy felhőplatformok, mint az Amazon, a Google, a Microsoft és az Oracle jövőre az elsők között kínálják majd ezeket az új GPU-kat. Bár a H200 árát egyelőre nem hozták nyilvánosságra, várhatóan prémium beruházás lesz, ami tükrözi a fejlett képességeit és a csúcstechnológiás AI feldolgozó teljesítmény iránti nagy keresletet.

- Legfrissebb

- Nem a technológia hiányzik, hanem a szokás: az Eurostat szerint az európaiak többsége nem érzi szükségesnek az AI-eszközöket

- A Google törölte a Disney-szereplős AI-videókat a YouTube-ról, miután felszólító levelet kapott

- Codex Mortis: ez a videójáték már teljes egészében mesterséges intelligenciával készült, ki is próbálhatod

- GPT-5.2 bemutató: az OpenAI új csúcsmodellje már nem csak válaszol, hanem munkatársként működik

- Hogyan növekednek gyorsabban a vállalkozások az AI-alapú digitális marketingplatformokkal?

- Meglepő igazság: több milliárdos interakció elemzéséből derült ki, hogyan is használjuk a mesterséges intelligenciát

- Az AI-tagadás mint vállalati kockázat: tényleg csak digitális moslékot csinál a mesterséges intelligencia?

- Ez lesz az OpenAI új gyónási rendszere: amikor a modell maga vallja be, ha hibázott

- A chatbotok sokkal hatékonyabban formálják a politikai véleményt, mint a tévés kampányhirdetések

- Áttörés a mellrákszűrésben? A DeepHealth új platformja már most átírja a radiológia jövőjét

- Képernyőidő

- Tudományos felfedezés: a testmozgás az agyunkat is megváltoztatja?

- Halálunk után a mesterséges intelligencia kezelné tovább a Facebook profilunkat?

- Drop Duchy – Complete Edition teszt szülőknek

- 2026-ban a laptop, a router, az okostelefon, de még a netszolgáltatás is drágulhat, ennek pedig a memória az oka

- Rekordot döntött a téli olimpia nézettsége: tarolt az HBO Max streaming és az Eurosport Magyarországon is

- Legnépszerűbb címkék

- OpenAI

- ChatGPT

- generatív AI

- AI

- Microsoft

- innováció

- NVIDIA

- GPT-4

- technológia