A Falcon 180B: A hatékony nyílt forráskódú aI-modell, amelyből hiányoznak a védőkorlátok

A Falcon 40B utódja, a Falcon 180B viharszerűen meghódította az AI világát, de egy elég nagy hiányossággal, ami miatt óvatosságra intenek a fejlesztők.

-

A Falcon 180B, a Falcon 40B csapat új kiadása, egy nagy teljesítményű AI-modell, amely a természetes nyelvi feladatokban ért el kiváló eredményeket.

-

Eredményei ellenére a Falcon 180B nem rendelkezik megfelelő védőkorlátokkal, ami potenciálisan problémás kimenetekhez vezethet.

Ha többet akarsz tudni, kövess minket Facebookon! -

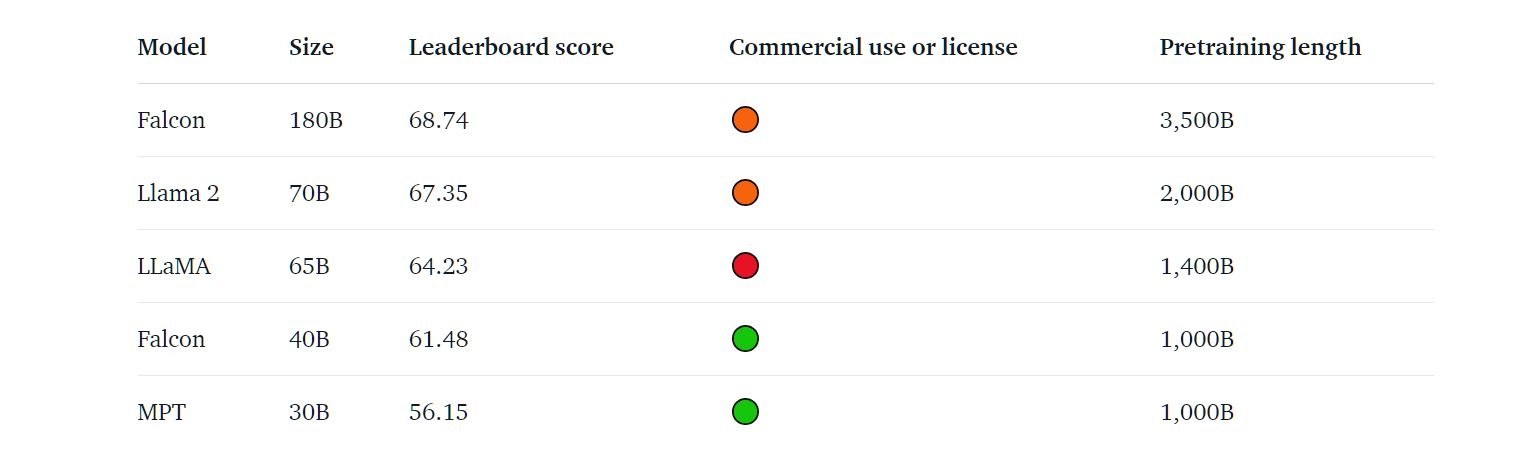

A modell kivételes teljesítményt mutatott, még az olyan óriásokat is megelőzte, mint a Google PaLM-2, a Meta Llama 2 és az OpenAI GPT3.5.

Az Abu Dhabi székhelyű Technológiai Innovációs Intézet (TII) bemutatta legújabb csodáját, a Falcon 180B-t, a Falcon 40B modell utódját. Ez az új verzió, amelyet a TII RefinedWeb adathalmazából származó 3,5 trillió tokenre képeztek ki, több mint négyszer nagyobb elődjénél. A teljesítménye nyilvánvaló, mivel a ranglistákon az első helyeket foglalja el, sőt, olyan óriásokat is megelőz, mint a Google PaLM-2.

Azonban minden rózsának megvan a maga tövise. A Falcon 180B legnagyobb hibája a megfelelő védőkorlátok hiánya. Ezzel a hiányossággal a modell olyan kimenetekhez vezethet, amelyeket az intézet „problematikusnak” nevez, különösen akkor, amikor erre felszólítják. A modell alapváltozata nem rendelkezik prompt formátummal sem, ami azt jelenti, hogy nem generál magától párbeszédes válaszokat.

Teljesítmény szempontjából a Falcon 180B egy olyan erő, amellyel számolni kell. A benchmark teszteken olyan versenytársakat utasított maga mögé, mint a Meta Llama 2 és az OpenAI ChatGPT-t hajtó GPT3.5. A koronát a Hugging Face Dicsőséglistája jelentette, ahol a legmagasabb pontszámot elért, nyílt forráskódú, előre betanított nagy nyelvi modell lett. A felhasználók és fejlesztők azonban a fent említett hiányossága miatt óvatosságra intenek.

- Legfrissebb

- Nem a technológia hiányzik, hanem a szokás: az Eurostat szerint az európaiak többsége nem érzi szükségesnek az AI-eszközöket

- A Google törölte a Disney-szereplős AI-videókat a YouTube-ról, miután felszólító levelet kapott

- Codex Mortis: ez a videójáték már teljes egészében mesterséges intelligenciával készült, ki is próbálhatod

- GPT-5.2 bemutató: az OpenAI új csúcsmodellje már nem csak válaszol, hanem munkatársként működik

- Hogyan növekednek gyorsabban a vállalkozások az AI-alapú digitális marketingplatformokkal?

- Meglepő igazság: több milliárdos interakció elemzéséből derült ki, hogyan is használjuk a mesterséges intelligenciát

- Az AI-tagadás mint vállalati kockázat: tényleg csak digitális moslékot csinál a mesterséges intelligencia?

- Ez lesz az OpenAI új gyónási rendszere: amikor a modell maga vallja be, ha hibázott

- A chatbotok sokkal hatékonyabban formálják a politikai véleményt, mint a tévés kampányhirdetések

- Áttörés a mellrákszűrésben? A DeepHealth új platformja már most átírja a radiológia jövőjét

- Képernyőidő

- Fallout 2. évad – kritika szülői szemmel a világ borzalmairól és a gyermeki ártatlanság elvesztéséről

- Tudományos felfedezés: a testmozgás az agyunkat is megváltoztatja?

- Halálunk után a mesterséges intelligencia kezelné tovább a Facebook profilunkat?

- Drop Duchy – Complete Edition teszt szülőknek

- 2026-ban a laptop, a router, az okostelefon, de még a netszolgáltatás is drágulhat, ennek pedig a memória az oka

- Legnépszerűbb címkék

- OpenAI

- ChatGPT

- generatív AI

- AI

- Microsoft

- innováció

- NVIDIA

- GPT-4

- technológia