Az Nvidia GH200 szuperchipje a generatív AI-t erősíti: megkezdődik a teljes körű gyártás

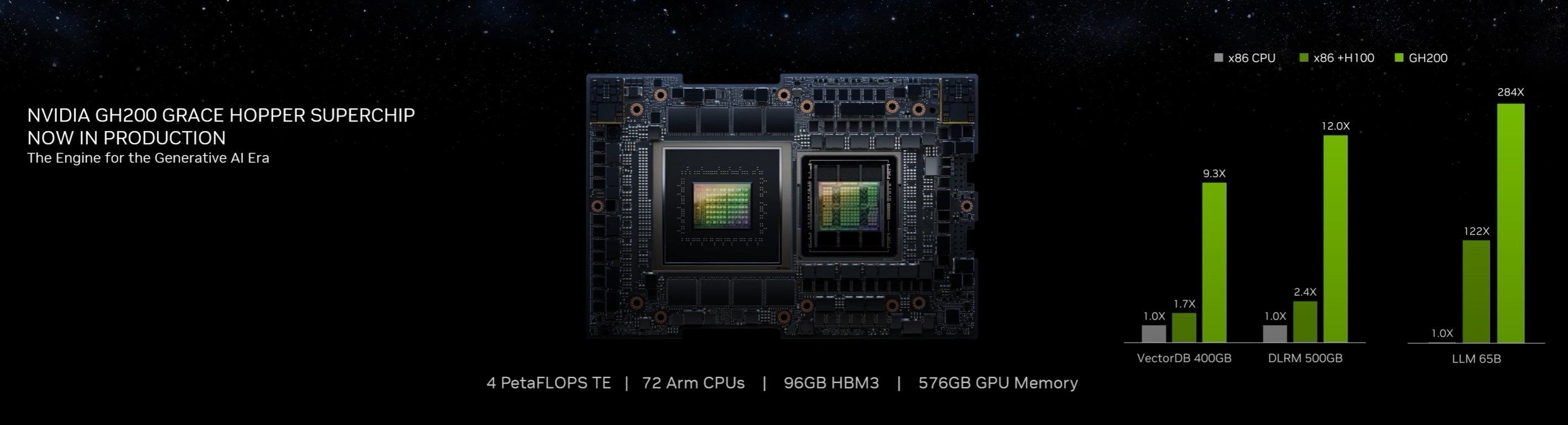

Az Nvidia megerősítette legújabb Grace Hopper GH200 Superchip-jének teljes körű gyártását, amelyet komplex AI-programok és nagy teljesítményű számítási munkaterhelések fokozására terveztek.

Az Nvidia a közelmúltban jelentette be a GH200 Grace Hopper Superchip teljes körű gyártását, amely a bonyolult AI-programok kezelésére tervezett nagy hatékonyságú eszköz. Emellett nagy teljesítményű számítási (HPC) munkaterhelések kezelésére is tervezték. A GH200-alapú rendszerek az Nvidia több mint 400 konfigurációból álló gyűjteményét egészítik ki, amelyeket az Nvidia legújabb CPU- és GPU-architektúrái köré terveztek, mint például az Nvidia Grace, az Nvidia Hopper és az Nvidia Ada Lovelace, és amelyek mind a generatív AI iránti növekvő igény kielégítését célozzák.

A tajvani Computex szakkiállításon Jensen Huang, az Nvidia vezérigazgatója további részleteket mutatott be a GH200 Grace Hopper Superchip-ről, amely az Arm-alapú Nvidia Grace CPU és Hopper GPU architektúrákat az Nvidia NVLink-C2C összekapcsolási technológián keresztül párosítja. Ez a kombináció elképesztő 900 GB/s teljes sávszélességet biztosít, hétszer többet, mint a hagyományos rendszerek hagyományos PCIe Gen5 sávjai. Ez a hatalmas számítási kapacitás a nagy igényű generatív AI- és HPC-alkalmazásokat szolgálja ki.

Ian Buck, az Nvidia gyorsított számításokért felelős alelnöke kiemelte a generatív AI átalakító szerepét olyan iparágakban, mint az egészségügy, a pénzügy, az üzleti szolgáltatások és sok más. Hangsúlyozta, hogy a GH200 szuperchipek teljes gyártásának megkezdésével a gyártók világszerte hamarosan biztosítják a vállalatok számára azt a felgyorsított infrastruktúrát, amelyre szükségük van a megkülönböztető saját adataikat hasznosító generatív AI-alkalmazások létrehozásához és telepítéséhez.

A tajvani gyártók a világszerte számos olyan rendszergyártó között vannak, amelyek a legújabb Nvidia technológiával működő rendszereket dobnak piacra. Ezek közé tartozik az Aaeon, Advantech, Aetina, ASRock Rack, Asus, Gigabyte, Ingrasys, Inventec, Pegatron, QCT, Tyan, Wistron és Wiwynn. Emellett olyan globális szervergyártók, mint a Cisco, a Dell Technologies, a Hewlett Packard Enterprise, a Lenovo, a Supermicro és az Atos vállalathoz tartozó Eviden is kínálnak különféle Nvidia-gyorsított rendszereket.

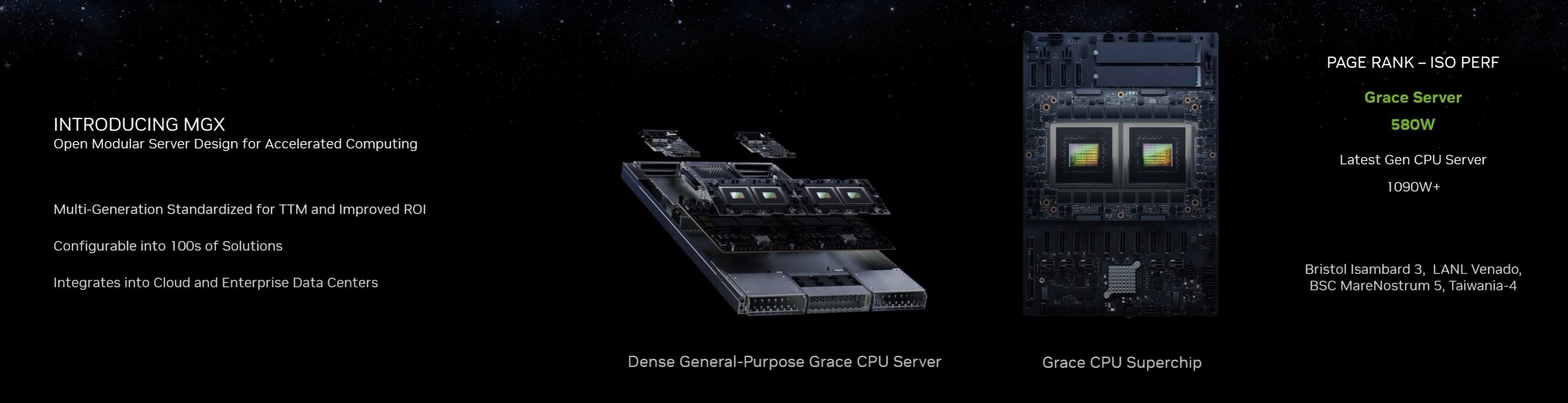

A különféle gyorsított számítási igények kielégítése érdekében az Nvidia bemutatta az Nvidia MGX szerverspecifikációt is. Ez a tervezet moduláris referenciaarchitektúrát biztosít a rendszergyártók számára a mesterséges intelligencia, a nagy teljesítményű számítástechnika és az Omniverse alkalmazások széles körének kiépítéséhez, hatékonyan csökkentve a fejlesztési költségeket és időt. Az ASRock Rack, az ASUS, a GIGABYTE, a Pegatron, a QCT és a Supermicro alkalmazza az MGX-et, amelynek célja az adatközpontok architektúrájának egyszerűsítése.

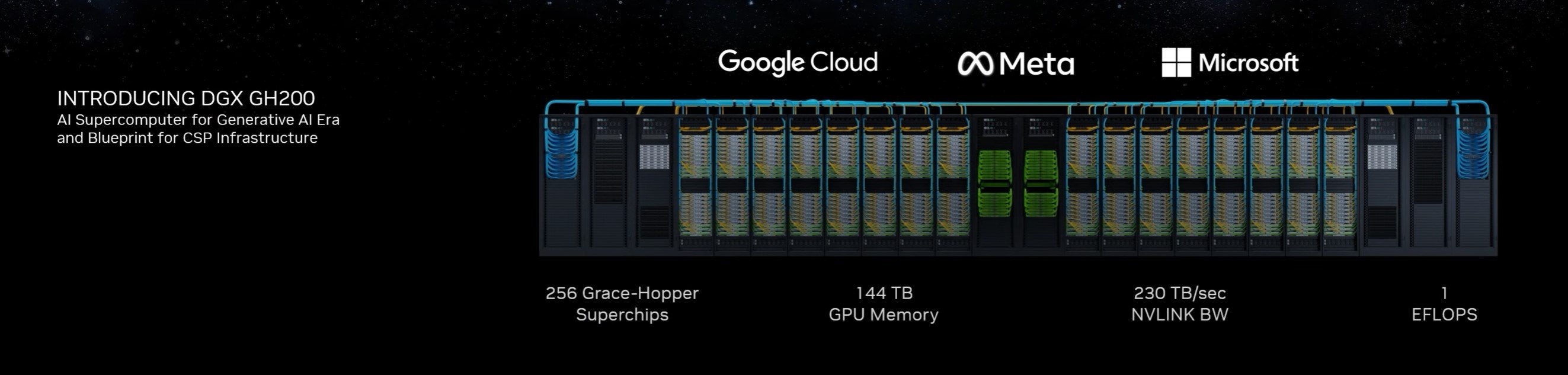

Az Nvidia egy új osztályú, nagy memóriájú mesterséges intelligencia szuperszámítógépet is bemutatott – az Nvidia DGX szuperszámítógépet, amelyet az Nvidia GH200 Grace Hopper Superchip-ek és az Nvidia NVLink kapcsolórendszer hajt. Ez a szuperszámítógép a generatív AI nyelvi alkalmazások, ajánlórendszerek és adatelemzési munkaterhelések óriási, új generációs modelljeinek fejlesztését hivatott elősegíteni. Az Nvidia DGX GH200 megosztott memóriaterülete 256 GH200 szuperchipet egyesít, hogy egyetlen GPU-ként működjön, így példátlan teljesítményt és megosztott memóriakapacitást kínál.

Végezetül az Nvidia bejelentette új szuperszámítógépét, az Nvidia Taipei-1-et, hogy még több gyorsított számítási erőforrást hozzon Ázsiába a mesterséges intelligencia és az ipari metaverzum alkalmazások fejlesztésének támogatására. Az Nvidia által üzemeltetett szuperszámítógép a tervek szerint még idén üzembe áll. Várhatóan a vezető tajvani oktatási és kutatóintézetek az elsők között férnek majd hozzá a Taipei-1-hez a fejlett egészségügyi ellátás, a nagy nyelvi modellek, az éghajlattudomány, a robotika, az intelligens gyártás és az ipari digitális ikrek kutatásának céljából.

- Legfrissebb

- Nem a technológia hiányzik, hanem a szokás: az Eurostat szerint az európaiak többsége nem érzi szükségesnek az AI-eszközöket

- A Google törölte a Disney-szereplős AI-videókat a YouTube-ról, miután felszólító levelet kapott

- Codex Mortis: ez a videójáték már teljes egészében mesterséges intelligenciával készült, ki is próbálhatod

- GPT-5.2 bemutató: az OpenAI új csúcsmodellje már nem csak válaszol, hanem munkatársként működik

- Hogyan növekednek gyorsabban a vállalkozások az AI-alapú digitális marketingplatformokkal?

- Meglepő igazság: több milliárdos interakció elemzéséből derült ki, hogyan is használjuk a mesterséges intelligenciát

- Az AI-tagadás mint vállalati kockázat: tényleg csak digitális moslékot csinál a mesterséges intelligencia?

- Ez lesz az OpenAI új gyónási rendszere: amikor a modell maga vallja be, ha hibázott

- A chatbotok sokkal hatékonyabban formálják a politikai véleményt, mint a tévés kampányhirdetések

- Áttörés a mellrákszűrésben? A DeepHealth új platformja már most átírja a radiológia jövőjét

- Képernyőidő

- Tudományos felfedezés: a testmozgás az agyunkat is megváltoztatja?

- Halálunk után a mesterséges intelligencia kezelné tovább a Facebook profilunkat?

- Drop Duchy – Complete Edition teszt szülőknek

- 2026-ban a laptop, a router, az okostelefon, de még a netszolgáltatás is drágulhat, ennek pedig a memória az oka

- Rekordot döntött a téli olimpia nézettsége: tarolt az HBO Max streaming és az Eurosport Magyarországon is

- Legnépszerűbb címkék

- OpenAI

- ChatGPT

- generatív AI

- AI

- Microsoft

- innováció

- NVIDIA

- GPT-4

- technológia