A Code Llama: Meta nyílt forráskódú programozási csodája

A programozás világa új szereplővel bővül: A Meta Code Llama, egy nyílt forráskódú nagy nyelvi modell.

-

A Meta kiadta a Code Llamát, egy generatív AI nagy nyelvi modellt, amelyet programozásra szabtak.

-

A Code Llamát úgy tervezték, hogy segítse a szoftvermérnököket a különböző ágazatokban, a kutatástól a vállalkozásokig.

Ha többet akarsz tudni, kövess minket Facebookon! -

A Code Llama család különböző paraméterekkel rendelkező modelleket tartalmaz, amelyek több programozási nyelvet támogatnak.

A Meta hivatalosan is elindította a Code Llama-t. Ezt az új generatív AI nagy nyelvi modellt (LLM) kifejezetten programozáshoz készítették. Általános célú társával, a LLaMA 2-vel ellentétben a Code Llama nyílt forráskódú és kereskedelmi felhasználásra is elérhető. A Meta víziója egyértelmű: a szoftvermérnökök támogatása minden területen, a kutatástól az iparon át a nyílt forráskódú projektekig és a vállalkozásokig.

A Code Llama bevezetése felrázza az AI-programozás színterét. Az OpenAI Codex, a Microsoft Github Copilot és más kódolás-központú LLM eszközök, például a Stack Overflow OverflowAI félelmetes versenytársaként jelenik meg. Mi különbözteti meg a Code Llamát? Ez az LLaMA 2 "kódra specializált" változata. Ez azt jelenti, hogy képes kódot generálni, meglévő kódot kiegészíteni, fejlesztői jegyzeteket készíteni, dokumentációt létrehozni és még a hibakeresésben is segíthet. Ezenkívül sokoldalú, számos nyelvet támogat, köztük Python, C++, Java, PHP, Typescript, C# és Bash nyelveket.

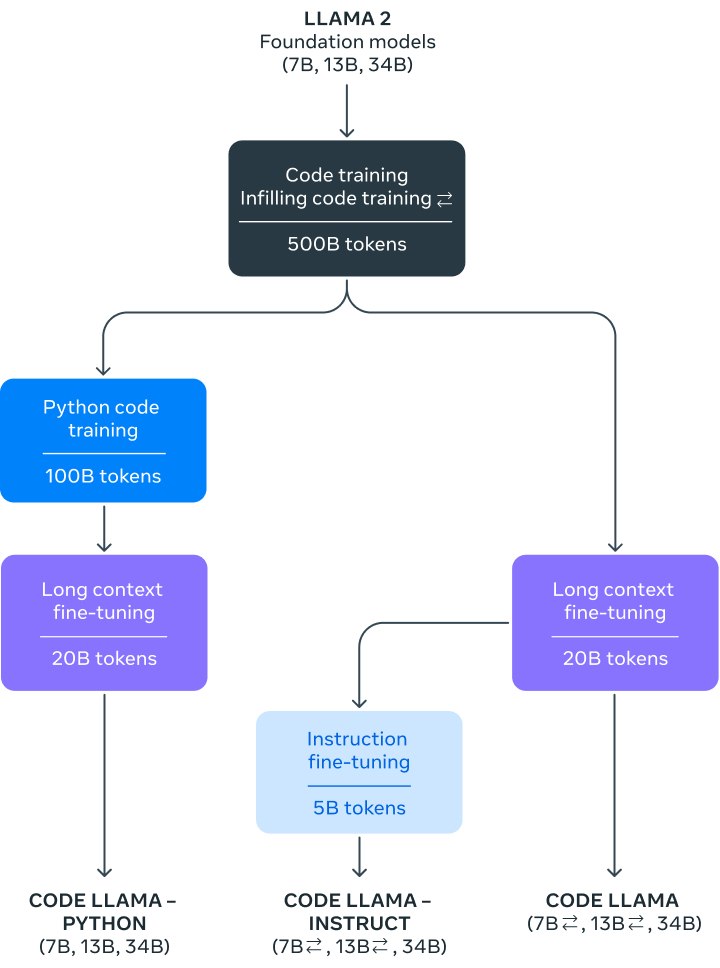

A Code Llama család három, változó paraméterekkel rendelkező modellel büszkélkedhet: egy 7 milliárd, egy 13 milliárd és egy 34 milliárd paraméteres modellel. Mindegyik modellt elképesztő 500 milliárd tokenen alapján képezték ki. A kisebb modellek, amelyeket a hatékonyság érdekében terveztek, kevesebb GPU-n futtathatók, így könnyebben hozzáférhetőek. Minden modell akár 100 000 tokent is képes kezelni a felszólításokhoz, így a felhasználók bőséges szövegkörnyezetet tudnak biztosítani a kódbázisukból. Ez meghatározóbb és pontosabb kódgenerálást biztosít. Emellett a LLaMA család finomhangolt modelleket tartalmaz Python és Instruct számára, amelyek biztonságosabb és kiszámíthatóbb kódkimeneteket biztosítanak.

- Legfrissebb

- Nem a technológia hiányzik, hanem a szokás: az Eurostat szerint az európaiak többsége nem érzi szükségesnek az AI-eszközöket

- A Google törölte a Disney-szereplős AI-videókat a YouTube-ról, miután felszólító levelet kapott

- Codex Mortis: ez a videójáték már teljes egészében mesterséges intelligenciával készült, ki is próbálhatod

- GPT-5.2 bemutató: az OpenAI új csúcsmodellje már nem csak válaszol, hanem munkatársként működik

- Hogyan növekednek gyorsabban a vállalkozások az AI-alapú digitális marketingplatformokkal?

- Meglepő igazság: több milliárdos interakció elemzéséből derült ki, hogyan is használjuk a mesterséges intelligenciát

- Az AI-tagadás mint vállalati kockázat: tényleg csak digitális moslékot csinál a mesterséges intelligencia?

- Ez lesz az OpenAI új gyónási rendszere: amikor a modell maga vallja be, ha hibázott

- A chatbotok sokkal hatékonyabban formálják a politikai véleményt, mint a tévés kampányhirdetések

- Áttörés a mellrákszűrésben? A DeepHealth új platformja már most átírja a radiológia jövőjét

- Képernyőidő

- Tudományos felfedezés: a testmozgás az agyunkat is megváltoztatja?

- Halálunk után a mesterséges intelligencia kezelné tovább a Facebook profilunkat?

- Drop Duchy – Complete Edition teszt szülőknek

- 2026-ban a laptop, a router, az okostelefon, de még a netszolgáltatás is drágulhat, ennek pedig a memória az oka

- Rekordot döntött a téli olimpia nézettsége: tarolt az HBO Max streaming és az Eurosport Magyarországon is

- Legnépszerűbb címkék

- OpenAI

- ChatGPT

- generatív AI

- AI

- Microsoft

- innováció

- NVIDIA

- GPT-4

- technológia