Két új, nyílt AI-modell, ami megreformálhatja a fejlesztők eszköztárát – itt a gpt-oss-120b és gpt-oss-20b

Open-weight AI-modellek új generációja érkezett, amely nemcsak erőteljes, de költséghatékony, biztonságos és végre valóban elérhető lehet a hétköznapi fejlesztők és kisebb cégek számára is.

A nyílt forráskódú AI-modellek világa hosszú ideje várta az áttörést, amely egyesíti a csúcsteljesítményt, a könnyű futtathatóságot és az átláthatóságot. Most megtört a jég: bemutatkoztak a gpt-oss-120b és gpt-oss-20b modellek, amelyek az OpenAI legfejlettebb módszerein alapulnak, mégis bárki számára elérhetők az Apache 2.0 licenc alatt.

Mit tudnak ezek a modellek?

A két modell a paramétereik száma szerint különbözik: a gpt-oss-120b 117 milliárd paraméteres, míg a kisebb gpt-oss-20b „csak” 21 milliárdos. Mégis, az igazi erősségük a hatékonyságuk és az alkalmazkodóképességük. A gpt-oss-120b: közel azonos teljesítményt nyújt, mint az OpenAI o4-mini modell, de fut egyetlen 80 GB-os GPU-n is.

gpt-oss-20b: a meglepően kompakt modell 16 GB memórián is elboldogul, így tökéletes mobileszközökre, on-device futtatásra vagy alacsony költségű lokális inferenciára.

A legtöbb nyílt modell eddig nem közelítette meg a zárt modellek, például a GPT-4 teljesítményét, különösen összetett feladatoknál, például:

- több lépéses érvelésnél (CoT),

- eszközhasználatnál (például Python-futtatás),

- vagy egészségügyi kérdések megválaszolásánál.

A gpt-oss modellek viszont ezeken a területeken kivételesen jól teljesítenek – sőt, több esetben le is körözik a GPT‑4o-t vagy az OpenAI o3-széria modelljeit.

Milyen technikai újítások rejtőznek mögötte?

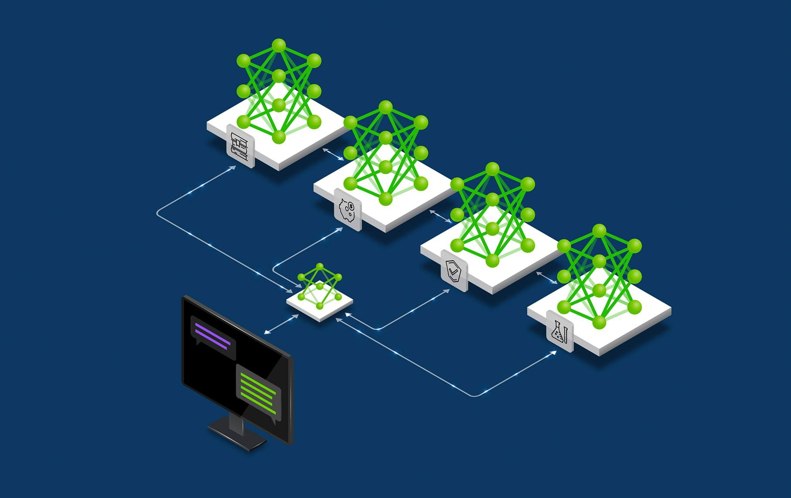

A modellek Transformer-alapúak, és a következő technológiákat ötvözik:

- Mixture-of-Experts (32–128 szakértő, mindig csak 4 aktív)

- Grouped Multi-Query Attention: memóriatakarékos figyelemmechanizmus

- Sparse Attention: vegyes sűrűségű figyelmi mintázatok

- 128k context length: a modellek natívan támogatják a rendkívül hosszú

- szövegkontextust

- RoPE pozíciós kódolás

Ezek a kombinációk lehetővé teszik, hogy a modellek alacsonyabb memóriaigény mellett is kiválóan működjenek, még hosszú feladatok során is.

A gpt-oss modellek fejlesztői a nyílt modellek kapcsán szigorúbb biztonsági követelményeket alkalmaztak. Egy kifejezetten ellenőrző célra finomhangolt változatot is értékeltek a saját Preparedness Framework szerint, így:

- nem csak technikailag, hanem etikailag is biztonságosan használhatók,

- megfelelnek a vállalat legújabb belső biztonsági mércéinek,

- a biztonsági eredményeket nyilvánosan is megosztották a model cardban és kutatási jelentésekben.

A modellek kompatibilisek a Responses API-val, támogatják az agentic workflow-kat, többféle reasoning-effort szint választható, a válaszokat pedig akár strukturált formátumban is vissza lehet kapni. Emellett:

- teljesen testreszabhatók,

- képesek CoT használatára,

- kiválóan működnek eszközökkel (pl. Python kód futtatás, keresés),

- futtathatók helyben, akár egyetlen GPU-n vagy edge-eszközön is.

A gpt-oss-120b és gpt-oss-20b modellek valódi áttörést jelentenek az open-weight nyelvi modellek világában. A teljesítmény, hatékonyság, skálázhatóság és biztonság együttállása lehetővé teszi, hogy a fejlesztők és vállalatok saját infrastruktúrán futtathassanak versenyképes AI-megoldásokat – a zárt modellek korlátozásai nélkül.

- Legfrissebb

- Nem a technológia hiányzik, hanem a szokás: az Eurostat szerint az európaiak többsége nem érzi szükségesnek az AI-eszközöket

- A Google törölte a Disney-szereplős AI-videókat a YouTube-ról, miután felszólító levelet kapott

- Codex Mortis: ez a videójáték már teljes egészében mesterséges intelligenciával készült, ki is próbálhatod

- GPT-5.2 bemutató: az OpenAI új csúcsmodellje már nem csak válaszol, hanem munkatársként működik

- Hogyan növekednek gyorsabban a vállalkozások az AI-alapú digitális marketingplatformokkal?

- Meglepő igazság: több milliárdos interakció elemzéséből derült ki, hogyan is használjuk a mesterséges intelligenciát

- Az AI-tagadás mint vállalati kockázat: tényleg csak digitális moslékot csinál a mesterséges intelligencia?

- Ez lesz az OpenAI új gyónási rendszere: amikor a modell maga vallja be, ha hibázott

- A chatbotok sokkal hatékonyabban formálják a politikai véleményt, mint a tévés kampányhirdetések

- Áttörés a mellrákszűrésben? A DeepHealth új platformja már most átírja a radiológia jövőjét

- Képernyőidő

- Már csak egy napig érhető el Steamen a táblás játékok akciója, érdemes még gyorsan körbenézni

- Mi ez a Google által készített Project Genie, amely éppen bedönti a játékfejlesztő cégek részvényeit?

- A gyerek, aki nem tud nyugton ülni – hiperaktivitás vagy a test üzenete?

- Sydney Sweeneyvel és a Deadpool íróival készül filmadaptáció a világ egyik legelismertebb kooperatív videójátékából

- Egy új tanulmány szerint a képernyőidő korlátozása egyáltalán nem megoldás már semmire

- Legnépszerűbb címkék

- OpenAI

- ChatGPT

- generatív AI

- AI

- Microsoft

- innováció

- NVIDIA

- GPT-4

- technológia